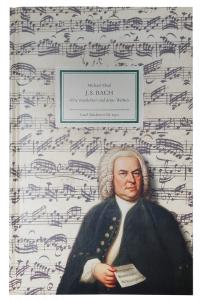

Die Geschichte ist aus dem Ruder gelaufen. Begonnen hatte sie mit diesem Buch von der Vorschlagsliste meines örtlichen Buchhändlers. Über Johann Sebastian Bach habe ich schon so Einiges gelesen, Michael Maul gilt jedoch als ausgesprochener Kenner dieses barocken Musikers. Seine Biografie spricht Bände. Kaum begonnen, stieß ich auf den Hinweis zu einer umfangreichen Podcast-Serie im Deutschlandfunk, «Universum JSB». Schon einige Jahre alt, aber Johann Sebastian ist ja schon lange nicht mehr unter uns. Also hörte ich einmal rein. Was zur Folge hatte, dass die 33 halbstündigen Beiträge mich eine ganze Zeit in Anspruch nahmen. Noch schlimmer, am Ende jeder Folge wollte ich die nächste kaum abwarten. So ging die Zeit ins Land, erst danach konnte ich zum Buch zurückkehren. Ich stieß erstmals auf Bach in einer Zeit, als solche Musik für Youngsters absolutes No-Go war. Walter Carlos bzw. Wendy brachte ihn mir nahe, wenn auch auf einem ungewöhnlichen Instrument. So erkannte ich dann, was Leute wie Keith Emerson oder Rick Wakeman als wirkliche musikalische Wurzeln hatten. Wen sie da oft in ihrer Musik zitierten. Im Grunde gehören das Buch sowie die darin verwiesene Spotify-Playlist als auch der Podcast zusammen, liefern ein unglaublich breites wie unterhaltsames Wissen über den großen Musiker des Barock. Ja, ich habe eine Menge Neues erfahren. Das Eine oder Andere sogar erst jetzt verstanden.

Die Geschichte ist aus dem Ruder gelaufen. Begonnen hatte sie mit diesem Buch von der Vorschlagsliste meines örtlichen Buchhändlers. Über Johann Sebastian Bach habe ich schon so Einiges gelesen, Michael Maul gilt jedoch als ausgesprochener Kenner dieses barocken Musikers. Seine Biografie spricht Bände. Kaum begonnen, stieß ich auf den Hinweis zu einer umfangreichen Podcast-Serie im Deutschlandfunk, «Universum JSB». Schon einige Jahre alt, aber Johann Sebastian ist ja schon lange nicht mehr unter uns. Also hörte ich einmal rein. Was zur Folge hatte, dass die 33 halbstündigen Beiträge mich eine ganze Zeit in Anspruch nahmen. Noch schlimmer, am Ende jeder Folge wollte ich die nächste kaum abwarten. So ging die Zeit ins Land, erst danach konnte ich zum Buch zurückkehren. Ich stieß erstmals auf Bach in einer Zeit, als solche Musik für Youngsters absolutes No-Go war. Walter Carlos bzw. Wendy brachte ihn mir nahe, wenn auch auf einem ungewöhnlichen Instrument. So erkannte ich dann, was Leute wie Keith Emerson oder Rick Wakeman als wirkliche musikalische Wurzeln hatten. Wen sie da oft in ihrer Musik zitierten. Im Grunde gehören das Buch sowie die darin verwiesene Spotify-Playlist als auch der Podcast zusammen, liefern ein unglaublich breites wie unterhaltsames Wissen über den großen Musiker des Barock. Ja, ich habe eine Menge Neues erfahren. Das Eine oder Andere sogar erst jetzt verstanden.

Beiträge

Nein, ich bin nicht arm. Nicht wirklich. Aber ich habe in meiner neuen Wohnung das Problem, dass die Wohnung sehr groß ist. Also ein Luxusproblem. Mein Arbeitszimmer ist ein Schlauch, der nur mit großem Aufwand für Sprachaufnahmen ruhig zu bekommen ist. Daran arbeite ich noch. Aber was bis dahin mit den Beiträgen, die in den nächsten Wochen abgeliefert werden müssen? Eine richtige Sprecherkabine möchte ich nicht, und sie wäre teuer und aufwändig.

Es hat mich interessiert, wie sich meine fünf Mikros so schlagen, wenn sie in gleicher Aufnahmesituation, mit gleichem Text, an den Start gehen. Ich wollte einfach wissen, welches mein Favorit ist. Am Ende war es wie vorher klar.

Normalerweise habe ich in Niedersachsen mein Kellerstudio, perfekt gedämmt, den PC am anderen Ende des Raumes mit Absorbern akustisch abgetrennt, nur Monitor und Maus auf dem Aufnahmetisch. Gelegentlich möchte ich gerne auch in meiner Behausung in Ostwestfalen kurze Texte einsprechen, manchmal nur wenige Minuten lang. Doch selbst das Schlafzimmer mit Bett und Wandbehang ist zu hallig, wenn auch ruhig. Was tun? In solchen Fällen kann ein Micscreen wie von Thomann helfen. Hier fängt das Angebot bei knapp unter 50 Euros an, nach oben hin fast offen. Für mich wesentlicher war, dass ich bei nur gelegentlicher Nutzung den Micscreen auch verstauen muss. Und jedes Mal erst in den Keller zu laufen, macht die Sache nicht einfacher. Das muss doch anders, billiger und einfacher gehen. Tut es auch.

Man nehme:

- Zwei Platten Dämmschaumstoff, billig und mit viel Auswahl beim Pyramidenkönig; Pyramiden dämpfen besser, Noppen sind flacher; ich habe 7 cm-Pyramiden genommen.

- Zwei Hartschaumplatten 50 x 50 cm aus dem Baumarkt, alternativ auch Sperrholz (schwerer, aber stabiler). Weißer Hartschaum und weißer Schaumstoff sehen besser aus. Sonst das Sperrholz mit Spühfarbe bearbeiten.

- Zwei kleine Möbelscharniere.

- Klebstoff, klassisches Pattex für Platten und Scharniere, oder Sekundenkleber bzw. alternativ Senkkopfschrauben und Muttern für die Scharniere.

Die beiden Platten mit den Scharnieren verbinden, dabei bei den Scharnieren darauf achten, dass die Platten nach hinten ganz zusammen geklappt werden können. Den Schaumstoff auf der Vorderseite der Platten aufkleben, an der Verbindungsseite etwas Abstand lassen. Geht, weil die Schaumstoffplatten nicht ganz 50 cm lang sind. Fertig. Materialaufwand unter 15 Euros, Arbeitszeit eine Viertelstunde. Leicht angewinkelt stehen die Platten auf jedem Tisch. Unbenutzt verschwindet der Billig-Micscreen unter dem Bett oder im Schrank. Zwar kann man mit solchen Mitteln kein Badezimmer in eine Sprecherkabine verwandeln, aber für den Aufwand sind die Ergebnisse ganz brauchbar. Man bekommt den eigentlichen Hall nicht heraus, jedoch werden die hohen Frequenzanteile im Hall reduziert. Vielleicht ordere ich doch mal einen größeren Schirm bei Thomann und vergleiche die Ergebnisse.

Schlafzimmerstudio - ohne Micscreen

Schlafzimmerstudio - mit Micscreen

Man hat nicht oft die Gelegenheit, zwei vergleichbare Produkte im echten AB-Test unter die Lupe nehmen zu können. Manchmal aber doch, denn nach einem USB-Audiointerface von Focusrite habe ich mir noch eins von Steinberg zugelegt, weil ich keine Lust zum ständigen Umbauen hatte. Ich hätte auch gleich ein zweites Focusrite nehmen können, doch die Neugier war zu groß. Einfach kann jeder. Um es vorweg zu nehmen, steht das Steinberg im Keller in der Aufnahme, das Focusrite oben im Arbeitszimmer an der Abmischstation. Weil sich eben heraus stellte, dass die Produkte zwar funktional sehr ähnlich sind, aber doch ihre Stärken und Schwächen haben. Nein, Schwächen haben beide nicht. Nur die Stärken sind unterschiedlich.

Im Focusrite werkelt eigene Hardware von Focusrite. Im Steinberg ist Yamaha-Hardware verbaut, was man spätestens bei der Treiberinstallation sieht. Beide Treiber laufen ohne Probleme, die angeblich instabilen Treiber von Steinberg sind mir nicht untergekommen. Nach der Installation jeweils von CD liefen die Interfaces ohne Murren. Nur auf der Focusrite-CD war ein alter Treiber, doch auf der Website gibt es neue Versionen.

Technische Details spare ich mir, die finden sich für Focusrite und Steinberg zuhauf im Netz. Gemeinsam sind UR22 und 2i2 zwei symmetrische Eingänge für Mikrofone oder Line-Signale über eine Kombibuchse, ein 6,3 mm-Kopfhörerausgang und zwei symmetrische Ausgänge für Monitore über 6,3 mm-Klinke. Nur das UR22 hat noch zusätzlich ein MIDI-Interface und für einen der Eingangskanöle einen Hi-Z-Eingang für E-Instrumente. Allerdings mit Grenzen, denn der Eingangswiderstand ist mit 500 kOhm nicht wirklich hochohmig. Für mich irrelevant, denn ich produziere nur Sprache. Wird nur ein Eingang genutzt, wird mono auf beide Stereokanäle geroutet. Nutzt man beide Eingänge, wird konventionell auf die beiden Stereo-Kanäle geroutet. Monitor und Kopfhörer sind beim 2i2 getrennt regelbar. Beim UR22 gibt es einen Blend-Regler, dazu gleich mehr.

Kleiner Tipp am Rande. Hat man noch einen Behringer-USB-Treiber für deren Mischpulte installiert, ist in der Aufnahme auf dem PC ein unregelmäßiges Ticken zu hören. Bei beiden Interfaces, 2i2 wie UR22. Ist also Schuld des Behringer-Treibers. Hat mich etwas Suchen gekostet, weil ich erst WLAN oder ACPI im Verdacht hatte. Behringer-Treiber deinstalliert und es ist Ruhe.

Bedienung

Der große Regler für den Monitorausgang ist beim 2i2 als Audioausgang hilfreich, man kann schnell mal den Pegel herunter drehen. Dafür ist der Regler für den Kopfhörer etwas klein geraten. Für die Wiedergabe hat das 2i2 damit einen Vorteil. Dafür ist die Frontplatte des UR22 insgesamt aufgeräumter, aber wieder nicht so markant zu bedienen. Auch die Aussteuerung der Eingänge fällt beim 2i2 durch die dreistufige Anzeige rund um den Pegelsteller (grün/gelb/rot) leichter, das UR22 hat nur eine einzelne rote LED für die Übersteuerung. Steinberg hat sich für das Routing eine Art Balanceregler ausgedacht, der zwischen Eingang und PC, als DAW bezeichnet, überblendet. Nette Idee, in der Praxis aber wenig hilfreich. Das 2i2 hat für das Routing einen Schalter, ob man den Input auf dem Monitor haben will. Man sieht hier schneller, warum man hier oder dort nichts hört. Ansonsten haben beide Interfaces ein schweres Metallgehäuse mit Gummifüßen, da rutscht nichts und die beiden stehen satt und fest auf dem Tisch. Alle Buchen schön fest verschraubt, beim UR22 prangt ein dickes Neutrik auf den Kombibuchsen, die beim 2i2 funktionieren genau so gut. Der Kopfhörerregler beim 2i2 könnte etwas stabiler sein. Wirklich wackelig ist er nicht.

Im Punkt Bedienung würde ich dem 2i2 wegen des großen Monitor-Reglers, der intuitiveren Benutzung und der besseren Aussteuerungsanzeige den Vorzug geben. Ganz knapp.

Aufnahme

Bei beiden Geräten werden die Vorverstärker generell gelobt. In der Tat arbeiten auch beide für 139 Euro Preis ausgesprochen rauscharm. Bei dynamischen Mikros kommen beide an Grenzen und liefern den relativ größten Rauschpegel. Bei Kondensator-Mikros dagegen bleibt es sehr still, mit einem Rode NT1A und selbst dem billigen Thomann-Stäbchen ist keinerlei Rauschen zu hören. Mit dynamischen Mikros löst mein FetHead das Problem, das Rauschen ist dann absolut akzeptabel, nicht einmal das Gating-Plugin spricht an. Und wir sind hier auf der kompletten Preamp-Seite immer noch bei unter 200 Euro, nicht bei 2000.

Bei den Vorverstärkern liegen UR22 und 2i2 gleichauf. Das Rauschen des 2i2 klingt etwas dunkler als beim UR22, was manchmal weniger aufdringlich sein kann. Wirklich hörbar wird es nur mit dynmischen Mikros, und bei Sprachaufnahmen mit niedrigen Pegeln und deutlichen Pausen. Die Aufnahmen sind detailliert, luftig und klingen frei. Selbst die feinsten Details eines Großmembraners sind genaustens mitgenommen. Das geht in diesem Preisbereich kaum besser. Ein Patt.

Wiedergabe

Tatsächlich ist da ein Unterschied zwischen 2i2 und UR22. Das UR22 klingt sehr analytisch, mit ausgesprochen kristallinen Höhen. Zeichnet dadurch auch jedes noch so kleine Detail zwischen die Monitore. Das 2i2 klingt dagegen weicher und musikalischer, zeichnet auch sehr detailliert, aber nicht mit dieser etwas aufdringlichen Präsenz. Bei Sprache treten die Unterschiede nicht so deutlich hervor wie bei Musik. Bei längerem Hören von Musik jedoch fand ich das UR22 anstrengend.

Gemeinsam ist den beiden wieder die absolute Abwesenheit von Rauschen (Monitoring war direkt über eine Alesis-Endstufe und KRK R6-Monitore). Über Kopfhörer war dieser Klangunterschied nicht ganz so deutlich, aber immer noch wahrnehmbar (AKG K240 Studio). Noch ein Wermutstropfen am Rande: der Ausgangspegel des 2i2 für den Kopfhörer könnte ein Schüppchen mehr Pegel gebrauchen. Für mich reicht es, wer Live-Aufnahmen in der Kneipe aufzeichnet, kann für das 2i2 einen zusätzlichen KH-Verstärker gut gebrauchen. Da ich mehr Cmoy47-Verstärker als notwendig habe, kein Thema.

Fazit

Für unter 150 Euro sehr gute Preamps, vergleichbare Funktionalität, viel Metall und das 2i2 in der Bedienung einen Tucken angenehmer bei der Abhöre. Trotzdem war das UR22 kein Fehlkauf, beide Interfaces leisten für diesen Preis erstaunliche Dinge. Der Test hat für eine praktische und gute Arbeitsteilung gesorgt. Das UR22 kommt beim Einsprechen zum Einsatz, weil die Aufnahmen beider Interfaces kaum zu unterscheiden sind. Das 2i2 ist für das Produzieren zuständig, weil es weniger angestrengt und ausgeglichener klingt. Und weil man den großen Monitor-Regler schneller im Zugriff hat. Das UR22 wurde einmal im Studio eingepegelt, danach wird es nicht mehr angefasst und die weniger klare Bedienstruktur stört nicht mehr.

Alle kritisierten Punkte sind Meckern auf hohem Niveau. Beide USB-Interfaces arbeiten klaglos und für diese Preiszone mit erstaunlich guten Ergebnissen. Ich frage mich nur, wo die Entwicklung der Technik noch hin geht. In ein paar Jahren bekommt man wohl Audiointerfaces von heute zu 2000 Euro für 100.

Was dem Einen seine Volksmusik, ist dem Anderen Death Metal oder Punk. Dann wären da noch die Freunde der Klassik und die Anhänger des Irish Folk, gerade die Deutschen scheinen ein Volk zu sein, das Schubladen braucht. Auch und gerade in der Musik. Doch gibt es Musiker, die in vielen Lagern Zuspruch erhalten, weil sie eben keine Schublade bedienen und zwischen diesen Welten wandern. Einer dieser Ausnahmemusiker ist der norwegische Saxophonist Jan Garbarek. Und der war am 11. Oktober 2012 wieder in der kleinen Großstadt an der Pader zu sehen und zu hören.

Meistens im Herbst erwartet man ihn. Er kommt leider nicht regelmäßig, manchmal wartet man mehrere Jahre. Und dann kommt er nicht im Herbst, sondern im späten Winter. Nein, nicht von einem jahreszeitlichen Sturm ist die Rede, sondern vom norwegischen Saxophonisten Jan Garbarek. Am 11. Oktober 2012 war es wieder so weit. Die Jan Garbarek Band in der Paderhalle.

Hängen die ersten Plakate, ist nicht mehr viel Zeit für den Besuch des Vorverkaufs, oft sind in kurzer Zeit seine Konzerte ausverkauft. Sie sind in Paderborn eine Institution geworden, wie das Volksfest Libori oder das Schützenfest. Dass Jan Garbarek so regelmäßig in dieser Stadt in Ostwestfalen auftritt, hat wohl mehrere Gründe. Einer ist sicherlich, dass das Jazz-Publikum hier ihn hör- und spürbar schätzt, weil er die Mentalität dieser schon irgendwie norddeutschen Gegend so trifft wie wenige andere. Der Tenor-Saxophonist, der den nordischen Jazz wie kaum jemand sonst populär machte, ihn in gewisser Weise repräsentiert. Als typischer Nordeuropäer hat sich Garbarek dann in den 70er Jahren sein Image erworben: kühl, kontrolliert, beinahe distanziert. Doch dieser Abend sollte zeigen, dass das Bild angepasst werden muss.

Der amerikanische Musiker und Komponist George Russell bezeichnete Garbarek als "Das größte Jazzmusik-Talent, das Europa nach Django Reinhardt hervorgebracht hat." Geboren am 4. März 1947 in Mysen in Norwegen, begann er mit 14 Jahren Saxophon zu spielen und gehört neben Terje Rypdal, Arild Andersen und John Christensen nun schon seit vielen Jahren zu den Big Four der norwegischen Jazz-Szene.

Der Abend des 11. Oktober, es ist noch nicht richtig Herbst, klar und trocken, nordisches Wetter. Ein stetiger Strom von Besucher verschwindet ruhig hinter den Türen der Paderhalle, im Foyer sammelt sich ein Publikum, das man am besten als gehobenes, liberales Bürgertum bezeichnen kann. Viele Leute jenseits der 50, wenige nahe der 30 Jahre. Die von Beton und wenig Holz geprägte kühle Atmosphäre will wohl so etwas wie einen Vorgeschmack der Musik Jan Garbareks geben. Ebenso der große Saal mit seinen fast 1000 Plätzen, die spärliche Bühnenausstattung mit einem großen Tuch im Hintergrund, das nur zwischen den Stücken die Farbe wechselt. Ausverkauft ist das Konzert dieses Mal nicht, aber sehr gut besucht. Das übliche Gemurmel vor Konzertbeginn, doch es ist nur leise, es trägt Vorfreude und Spannung auf die derzeitige Band von Garbarek. Weil man bei Jan Garbarek nie weiß, was einen nun erwartet.

Auf der aktuellen Tournee ist er mit seinem langjährigen Begleiter am Piano, Rainer Brüninghaus, dem Inder Trilok Gurtu an den Percussions und dem Brasilianer Yuri Daniel am Bass unterwegs. "Die menschliche Stimme ist mein Ideal", sagt Jan Garbarek und es gibt wohl kaum einen Saxophonisten, der diesem Ideal so nahe gekommen ist. Ulrich Greiner schreibt über ihn in der ‚Zeit‘: "Die Utopie des unendlichen Atems und des natürlichen Wohlklangs treibt Garbareks Musik an, sie schwitzt nicht, sie ist heiter im Sinn des Worts, das vom griechischen Aither kommt und klarer Himmel, reine Luft bedeutet."

Es ist kurz nach acht. Die Band beginnt mit einigen älteren Stücken von Garbareks Alben »Belonging« und »Places«. In dieser Besetzung gerät man schnell in die Gefahr wie die Fusionband Weather Report zu klingen. Doch nicht bei dieser Band, Garbareks Stimme und Ausdruck an diesem Instrument sind unverwechselbar, Rainer Brüninghaus ist ein exzellenter, aber genauso eigenwilliger Pianist in allen Stilen. Yuri Daniel spielt einen bundlosen elektrischen Fünfsaiter, zurückhaltend, sanft, sich nie in den Vordergrund spielend. Trilok Gurtu spielt Schlagzeug, indische Tablas, südamerikanische Congas und alles, was an Percussion verfügbar ist. Nach den eher klassischen Stücken Übergang zu moderneren Kompositionen. Und es kommt genau das, was so einmalig bei Garbarek ist: die Vier schöpfen aus allen musikalischen Stilen, vom klassischen Jazz über den Cool Jazz bis hin zu Melodien und Klängen aus dem Mainstream, Pop und Rock. Stetiger Wechsel der Solisten, Dialoge zwischen Bass und Saxophon, Piano und Bass, Schlagzeug und Saxophon. Brüninghaus und Gurtu liefern sich sogar einen Dialog zwischen Percussion und Piano, witzig, augenzwinkernd, mit einer Spielfreude, die man selten auf Jazzbühnen sieht. Dazwischen ein lächelnder, manchmal witzelnder Jan Garbarek.

Doch der große Teil des Abends gehört den anderen, Jan Garbarek zieht sich immer wieder zurück, überlässt seinen drei Mitmusikern das Feld. Bass- und Schlagzeug-Solos, in der populären Musik fast verschwunden, feiern hier ihre Rückkehr. In einem Moment noch sphärische, schwebende Klänge vom Saxophon und breite Klangteppiche vom Keyboard, dann wieder Rückkehr zu Sounds, die man eher im Hardrock erwartet. Es grooved, es stampft, es rockt. Dann wieder nur der Flügel, an dem sich Rainer Brüninghaus von der Neoklassik a’la George Winston über den Ragtime bis in den Freejazz arbeitet. Ständig ändern sich die Atmosphäre und der Klang, mal Solos, mal Duetts, dann wieder die komplette Band, doch immer passt es, immer ist es stimmig. Und alles ist erlaubt, auch Anleihen beim Pop und Synthesizer-Sounds. Das ist der Jan Garbarek, den sein Publikum liebt. Ständig präsent, aber nie vordergründig. Ständige Veränderung, aber immer er selbst. Und mit einer Stimme, die unverwechselbar und einmalig ist.

Gegen Ende gehört dem Inder Trilok Gurtu noch einmal allein die Bühne. Er beginnt mit einem Schlagzeug-Solo, geht über auf Tablas und Congas, legt einen Scat-Gesang darüber, es folgt eine Reise durch die Welt der Percussion, zu der bei ihm auch ein mit Wasser gefüllter Blecheimer gehört. Am Ende steigt Garbarek mit einer Obertonflöte ein und Garbarek und Gurtu beenden die Einlage mit einem furiosen Duo für Percussion und Flöte.

Nach weit über zwei Stunden Reise durch die Möglichkeiten, was Jazz auch sein kann, endet der Auftritt mit Standing Ovations und zwei Zugaben, die letzte schon unter Saalbeleuchtung. Vier großartige Musiker, zusammen wohl 100 Jahre Jazz-Erfahrung und dazu schier unglaubliches musikalisches und technisches Können.

Hier ein Lächeln auf den Gesichtern der Zuschauer, dort aber manchmal auch ein Grinsen. Weil diese Musiker sich selbst nicht immer ernst nehmen, sich nicht in den Olymp setzen, sondern auf dem Boden der musikalischen Realität bleiben. Und was macht die Jan Garbarek Band so einmalig? Dass sie sich aus allen Schubladen bedient und am Ende in keine mehr hinein passt. Und damit Freunde aus allen Schubladen findet.

Aktuelle Arbeiten an einer Reportage riefen mir eine Geschichte wieder in Erinnerung, die schon in den Analen der Geschichte versunken schien. Es muss 1972 gewesen sein, das 2. Internationale Jazz-Festival in Moers. Die Stadt war überlaufen, Unterkünfte kaum zu bekommen, und alle Restaurants und Kneipen hoffnungslos überfüllt. Wir schliefen auf dem Dachboden einer Schule, wo wir durch Glück und Zufall gelandet waren, unter diesen Bedingungen fast eine luxuriöse Bleibe. Und lustig war es dazu, denn bis zum Abend hatte sich der Dachboden mit einer gut gelaunten Gemeinde gefüllt. Wir hatten da diesen Wettbewerb, wer im Schlafsack hoppelnd am schnellsten von einer Ecke des Bodens zur anderen kam. Ok, da muss auch eine Menge Bier im Spiel gewesen sein.

Was jedoch nicht gegen den Hunger half. Unser Trupp spaltete sich auf, weil für zwei oder drei Leute eher etwas zu finden war als für ein herum streunendes Dutzend. Doch es schien aussichtslos. Eher aus der Not heraus erkundigten wir uns in einem jugoslawischen Restaurant. Alle Tische voll besetzt. Bis auf einen einzigen, an dem zwei Männer saßen. Als ich den Tisch näher inspizierte, wollte ich wieder gehen. Doch mein Freund Helmuth, für den Zurückhaltung kein sonderlich bekanntes Wort war, schleppte mich zu diesem Tisch zurück, fragte kurz, ob die beiden Plätze noch frei wären und bekam ein positives Signal. Wir setzten uns, ich mit einem etwas mulmigen Gefühl. Das war der Abend, als ich mit dem Posaunisten Albert Mangelsdorff und dem norwegischen Saxophonisten Jan Gabarek, zwei ganz großen Namen im Jazz, zu Abend aß.

Helmuth in seiner jungenhaften und freundlichen Art redete sofort los. Und es entstand schnell ein Gespräch. Was mir aber am meisten im Gedächtnis blieb, war nicht die freundliche, offene und feingeistige Art von Albert Mangelsdorff, sondern Jan Gabarek. Wie er mit der Nase über seinem Teller hing, das Essen nur mit der Gabel in unfassbarer Geschwindigkeit in sich hinein schaufelte und dabei kein einziges Wort sprach. Kaum war er fertig, warf er die Serviette auf den Teller, nickte Mangelsdorff kurz zu, sprang auf und verschwand. Wir sprachen noch eine ganze Weile, dann rief Mangelsdorff den Kellner, bezahlte, verabschiedete sich höflichst und ging. Ein denkwürdiger Abend.

Was ich damals partout nicht verstehen konnte, war die Tatsache, dass ein Mensch wie Jan Gabarek auf der Bühne eine so unglaublich emotionale und tiefgehende Musik machte, aber am Restauranttisch eine sehenswert proletenhafte Vorstellung ablieferte. Ich war noch zu jung um zu wissen und zu verstehen, dass Menschen so viele unterschiedliche Facetten haben können. Und dass das Eine nichts mit dem Anderen zu tun haben muss. Dass Mr Jekyll und Mr Hide keine Erfindungen sind, sondern wir alle diese Seiten haben.

Es sind diese Geschichten, die letzten Endes unsere Sicht der Welt prägen und die nicht umsonst so verhaftet sind. Und so ein grauer Kopp hat eine Menge solche Geschichten auf Lager. Am 11. Oktober sehe und höre ich Jan Gabarek wieder. Nur so nahe wie 1972 werde ich ihm nicht mehr kommen. Und doch habe ich das Gefühl, ich kenne ihn ein ganz klein wenig mehr als die anderen Besucher. Ich sage nur: Zigeunerspieß.

Als »Thick As A Brick« ("Dumm wie ein Stein") im Jahr 1972 als LP heraus kam, waren Konzeptalben und ProgRock hoch in Mode, die Zeiten von Gentle Giant, Tull, EL&P, King Crimson, Yes und Genesis, um nur Einige zu nennen. Dieses frühe Tull-Album sollte zu einem Meilenstein der Rockmusik werden wie auch »Tarkus« oder »The Lamb Lies Down On Broadway«. Sie waren Neuland, solche Musik und solche Musikformen waren noch nie gehört. Jedoch nur wenige Musiker wagen sich an einen Nachfolger für frühere Erfolge, auch Ian Anderson lehnte Sequels wie für »Aqualung« lange Zeit ab. Fast eine Ironie des Schicksales ist es, dass gerade Derek Shulman, Sänger und Frontman der damaligen »Gentle Giant«, schon lange Manager bei EMI, im Februar 2011 Ian Anderson dann doch überreden konnte. Nämlich zu einem Nachfolgealbum zu »Thick As A Brick«. Eine riskante Sache, denn ein Sequel muss sich immer an der Erstausgabe messen lassen, und diese Latte liegt hier besonders hoch.

Thematisch geht es in TAAB2 wieder um Gerald Bostock, aus dem kleinen Jungen ist nun nach vierzig Jahren ein abgewählter Labour-Abgeordneter geworden, der sich aufs Land zurück zieht und über die Was-wäre-gewesen-wenn-Fragen reflektiert. Der darüber nachdenkt, wie sich und warum sich alles so verändert hat, heute im Vergleich zu der Zeit, als es das Internet noch gar nicht gab, als die Telefone noch Wählscheiben und Social Media nicht den Schwatz über den Gartenzaun ersetzt hatten. Diese Gedanken trifft Anderson sehr gut und für die, die anno 1972 noch zur Schule gingen, die Tull-Fans 50+, vertraute Gedanken über Hedge-Fonds, vergangene Lieben und verlorene Chancen. Wie von Ian Anderson gewohnt ehrliche, lyrische und sprachverliebte Texte. Aber was ist nun mit der Musik?

Da leider ist nun mal die Zeit eine andere geworden, und auch die Menschen, die diese Musik machen, zu sehr hat sich bisher Ian Anderson in andere Gefilde orientiert. TAAB2 klingt musikalisch oft wie »Rupi's Dance« trifft »Rock Island«, doch der Geist dieser frühen Zeit mit TAAB und sein Klang lässt sich nicht reanimieren, TAAB war der Sound der Early Seventies, heute hat er etwas Altbackenes, so sehr Anderson sich auch bemüht, diesen Klang in den heutigen Tag herüber zu retten. Die harmonische Konsistenz, die klangliche Stichhaltigkeit von TAAB ist auf TAAB2 nicht mehr zu finden, die Musik wirkt produziert, oft sogar überproduziert, durcheinander geworfen und verzettelt. Mehr nach Produktion als nach Inspiration. Natürlich tauchen noch Reminiszenzen auf, die passen, ein hörenswertes Album, besonders, wenn man die Texte mitliest und verfolgt. So ist TAAB2 eher ein Statement, eine Rückschau, eine Besinnung auf Vergangenes. Etwas Neues konnte es nicht sein, und wurde es auch nicht. Selbst der Schluss ist nicht neu, wenn auch erlaubt an dieser Stelle, als Selbstzitat.

Mehr Ideen wie der Track »Adrift And Dumfounded«, dann wäre es wieder ein richtiges Tull-Album geworden. So bleibt es Stückwerk. Wenn auch an einigen Stellen die alte Tull durchscheint, für die, die seit »Aqualung« dabei sind. Dabei hätte gerade dieses Stück auch auf »Mistrel In The Galery« gewesen sein können. Aber genau das zeigt, dass dem Album ein Konzept fehlt.

Alte JT50Plus-Fans werden die CD sicher kaufen. Sie werden daran Freude haben, denn man erkennt so manches wieder, es weckt Erinnerungen. Für einen Moment. An »Thick As A Brick«, »Aqualung« geschweige denn »A Passion Play» reicht dieses Album nicht heran, nähert sich nicht einmal qualitativ oder vom Ideenreichtum her an. Versuch eines Sequels, gut gedacht, aber vielleicht auch zu hehres Ziel. Manche Dinge waren mal, und sie waren gut in ihrer Zeit, sie wieder zum Leben zu erwecken nicht immer mit Sinn bedacht oder auch nicht möglich.

Zwei von fünf möglichen Ziegelsteinen.

Wirklich begonnen hat ihre Karriere als junges Mädchen mit einem einzelnen Song, der es tatsächlich ganz schnell in die obersten Ränge der Hitparaden schaffte: »Babooshka« in 1980, sie hatte erst 1978 ihre erste eigene LP »The Kick Inside« heraus gebracht. Entdeckt wurde sie von keinem Geringeren als David Gilmour von Pink Floyd, so bekam sie ihren ersten Vertrag mit EMI. Seit weit über 30 Jahren ist sie nun im Geschäft und aus der unbekannten Sängerin ist eine feste Größe im immer unübersichtlicheren Markt der Pop-Musik geworden. Heute ist Kate Bush nicht nur Musikerin, sondern Marke. Sie steht für eine Musik, die sich angeblichen Regeln nicht beugen will.

Von einer Marke erwartet man gemeinhin, dass sie über die Jahre erkennbar und berechenbar bleibt, wie die Marken »Rolling Stones« oder »Elton John«. Aber genau das hat Kate Bush nie getan, spätestens seit »The Dreaming« in 1982 war klar, dass Kate Bush Entwicklung und Veränderung wollte, immer Neues und immer Anderes. Kommerzieller Erfolg oder Anpassung waren nicht ihr Ding, sie verpflichtete Jazzmusiker wie Eberhard Weber, osteuropäische Frauenchöre, arbeitete mit Peter Gabriel oder Nigel Kennedy. Trotz ihrer oft extravaganten Produktionen schaffte sie mit ihren Alben dreifaches Platin und stramm gefüllte Hallen. Und konnte es sich leisten, mal sechs oder acht Jahre nichts Neues heraus zu bringen.

Nach dem für Bush'schen Geschmack eher mainstreamorientieren Album »Aerial« in 2005 folgte Ende 2011 nun »50 Words For Snow«. Und wieder etwas ganz anderes als zuvor, Kate Bush scheint es zu lieben, Erwartungen zu enttäuschen, und das tut sie auf ihrem nun 10. Album wieder zuverlässig. Das erste Stück, »Snowflake«, wird in der ersten Stimme von Kate Bush's Sohn Albert McIntosh gesungen, Kate Bush begleitet. »Snowed In at Wheeler Street« ist ein Duett mit Elton John. Der Titletrack »50 Words For Snow« ist eine musikalisch untermalte Rezitation von Synonymen für das Wort Schnee, die vom englischen Schauspieler Stephen Fry vorgetragen werden. Beim ersten Hören eine merkwürdige Musik, die ein wenig an ihre Alben aus den Neunziger Jahren erinnert, in gewisser Weise experimentell, herkömmliche Songformen ignorierend, ruhig, aber nie langweilig. Ob alle Stücke überhaupt die Bezeichnung Song verdient haben, ist eine berechtigte Frage, wie sie das Rolling Stone-Magazin stellt.

Die Frankfurter Allgemeine Zeitung lobte »50 Words For Snow« als "tiefsinniges" und "intelligentes" Konzeptalbum. Und genau das ist es, aber das macht auch klar, dass das keine Musik für Parties ist. Es ist Musik für die ruhigen Stunden, für meditative Momente und erfordert Konzentration und Sicheinlassen auf diese Art von Musik. Und sie erschien zu einer genau passenden Zeit, als der erste Schnee sich auf die Landschaft legte.

Schwer zu beschreiben, aber empfohlen zu hören. Vier von fünf möglichen Schneemännern.

1994 begannen vier junge Nordiren mit simplem Rock. 17 Jahre später haben sie 11 Millionen CDs verkauft und sind von den Playlists vieler Radiosender nicht mehr weg zu denken. Zu Recht.

Obwohl wenige Leute den Namen der Band kennen, ihre Songs kennt fast jeder, der auch nur gelegentlich Pop-lastige Sender wie 1Live, NJoy oder Radio21 hört. 1998 erschien ihr Debutalbum »Music for Polarbears«, bis zu »Final Straw« in 2003 wurden Snow Patrol der Sortierung Alternative Rock gerecht, eine am amerikanischen Grunge orientierte, raue und direkte Stilform.

In 2006, mit der Veröffentlichung von »Eyes Open«, der Wandel zum Status Quo, Melodik und Form aus dem Grunge, aber nun Sound und Arrangement aus der Pop-Musik. Vermutlich wurde diese Entwicklung verursacht durch das Dazustoßen des Keyboarders Tom Simpson, aber auch durch die Rückkehr des Produzenten Jacknife Lee, Simpson ist für viele Songs verantwortlich, während die Texte weiter vom Sänger Gary Lightbody stammen. Songs wie »Shut Your Eyes«, »Chasing Cars« oder »You’re All I Have« sind von keiner Playlist moderner Formatsender mehr weg zu denken. Dieses Talent, Songs von gleichbleibender Güte quasi am Band zu produzieren, haben in der Tat wenige Bands. Eingängige Melodien mit komplexen Arrangements und einem großen Repertoire an Sounds und Stilformen, genau diese Linie setzt sich auf »Fallen Empires« fort.

Leichtfüßige Liebeslieder oder simple Balladen sind nichts für Snow Patrol. Vom Grunge ist die Ernsthaftigkeit geblieben, die Optimismus nicht ausschließt und Emotionen in den Vordergrund stellt. Keine simplen Pop-Songs für Aufzug oder Kaufhausberieselung, aber auch keine Musik, die nichts neben sich verträgt. Nicht umsonst holen sich Snow Patrol in den letzten Jahren Preise wie Best Irish Band oder Best British Group in Serie ab. Britischer Pop-Rock-Grunge vom Feinsten. Doch nie seelenlos oder oberflächlich.

Mit »Fallen Empires« wollten Snow Patrol im November 2011 ein weiteres Highlight setzen. Zum großen Teil gelingt das wie mit dem Titelstück »Fallen Empires« oder mit »This Isn’t Everything You Have«. Es ist großartige, klug gemachte und hervorragend produzierte Pop-Musik, hier sind sich Snow Patrol treu geblieben. Einziger Wermutstropfen ist, dass man die gleiche Sache nicht endlos abwandeln kann. Manche Songs klingen wie schon einmal gehört. Dann wieder taucht ein Song wie »The Garden Rules« auf, tatsächlich neu und erfrischend und ein Highlight des Albums.

Kennt man Snow Patrol von den früheren Alben, bringt »Fallen Empires« nicht so viel Neues wie »Eyes Open«, es ist kein Paradigmenwechsel mehr. Es ist das Weiterstricken bekannter Muster. An dieser Stelle könnte man etwas enttäuscht sein. Aber wegen der neuen Songs wird man auch als Snow Patrol-Kenner nicht um dieses Album herumkommen, doch Neues hören und Vertrautes schätzen. Wer gute, abwechselungsreiche Pop-Musik von Razorlight oder The Perishers mag und die Band noch nicht kennt, sollte spätestens mit dieser CD einen Einstieg wagen. An den Abwechselungsreichtum von »Up To Now« reicht »Fallen Empires« – leider – nicht heran.

Urteil: Dreieinhalb von fünf möglichen Schneeflocken.

Dem britischen Musiker und Songwriter David Peter Gray mit einer einzelnen CD nahe kommen zu wollen, ist ein ziemlich aussichtsloses Unterfangen. Seit den Neunziger Jahren steht David Gray auf Bühnen in Europa, Amerika und Australien, angefangen hat er nur mit Gitarre und Gesang in Pubs in Großbritannien. Es wurde eine Band, später kamen ein Cello hinzu und David spielte nun auch live überwiegend Piano. Ein Besuch seiner Website lässt inetwa erahnen, welche Entwicklung David Gray in den letzten zehn Jahren gemacht hat, nicht nur musikalisch, sondern auch persönlich.

»Foundling« ist die nächste CD nach seinem radikalen Schnitt vor »Draw The Line«, nach der weitgehenden Auflösung der seit Jahren existierenden Band. Gray kehrt ein ganzes Stück zurück zu seinen Wurzeln als Singer/Songwriter, das Pompöse wie in »Life In Slow Motion« ist Vergangenheit. Die Songs werden wieder emotionaler und nachdenklicher, die Musik und vor allem der Text stehen wieder im Vordergrund. Gray's Texte drehen sich oft um die vielfältigen menschlichen Beziehungen, um Leben, Einsamkeit, Vergänglichkeit. Und er hat ein seltenes Händchen dafür, die Stimmungen und Inhalte zusammen zu bringen.

»Draw The Line« forderte dem alten David Gray-Fan einige Anpassung ab, tatsächlich hatte Gray damals einen Strich gezogen. Ich musste erst wieder warm werden mit ihm, aber das phantastische »Kathleen« und »Full Steam« - mit Annie Lennox - machten es einfacher. Es klang im ersten Moment für mich nicht mehr nach David Gray, die Songs hatten sich in Struktur und Feeling verändert, doch mit der Zeit gewöhnte ich mich an diesen nun etwas anderen David Gray. Mit »Foundling« ist man wieder dabei, lyrische Texte, Songs zum Nachdenken und sich selbst wiedererkennen, Gedanken, die in so manchem Moment in den Vordergrund gelangen, dazu eine Songwriter-Musik, die nicht zwangsweise einem ABAB-Schema folgt. Und obwohl Gray's Texte oft zentrale Themen des Lebens berühren, verfällt er nie ins Pessimitische, Kitschige oder Peinliche. »The Old Chair«, »In God's Name« und »When I Was In Your Heart« sind großartige Songs, in Youtubefinden sich neuerdings auch eine Menge Mitschnitte aus dem Studio und live.

Wer Kiran Goss oder Martyn Joseph mag, sollte bei David Gray stöbern, seine Diskografie bietet auf allen Stufen etwas. Und »Foundling« ist wieder ein neuer David Gray. Bin mal gespannt, wie diese Geschichte mit Gray so weiter geht. Wenn man bedenkt, dass Gray früher kaum zu interviewen war, weil extrem schüchtern und zurückhaltend. Auch eine interessante Geschichte einer persönlichen Entwicklung, die bei Gray zu verfolgen ist.

Viereinhalb von fünf möglichen Stühlen.

Wenn man bedenkt, dass die britische Band Elbow seit 1990 existiert, ihre fünf Alben alle die britischen Top-20 erreicht haben und sieben Singles die Top-40, sind Elbow auf dem Kontinent recht unbekannt. Geändert hat sich das erst mit dem Track »Lippy Kids« von ihrer letzten CD »Build a Rocket Boys!« aus dem Frühsommer 2011. So kam ich an das Album und schon wegen des schönen Titeltracks, »Lippy Kids« war der Arbeitstitel der CD, musste das in meine Sammlung.

Während Elbow mit dem Album »Seldom Seen Kid« noch dem BritPop zumindestens nahe stand, ist »Build a Rocket Boys!« stilitisch schwer einzuordnen, vielleicht experimenteller oder Avangarde-BritPop? Elbow wagt sich nun an andere Sounds und Klangspielereien, verabschiedet sich oft von gewohnten Songstrukturen. Es ist kein eingängiger BritPop mehr, denn für dieses Genre fehlt die Gleichförmigkeit und Berechenbarkeit. Die Songs auf »Build a Rocket Boys!« wechseln in Stil und Ausdruck, gewohnte Erwartungen an Abläufe und Linien werden zuverlässig enttäuscht. Es ist kein Easy Listening, man kann die CD nicht eben mal auflegen und nebenbei hören, sie erfordert Aufmerksamkeit und Konzentration. Man könnte auch sagen, sie sei ziemlich widerborstig und sperrig. Keine einfache Musik, dafür ist sie trotz des Labels BritPop zu komplex und experimentell. Freundet man sich mit dem Kaleidoskop an Sounds und Strukturen an, kann man mit der Musik von Elbow warm werden. Aber es braucht für einen Kontinentaleuropäer etwas guten Willen und Geduld, die Briten tun sich mit solchen stilistischen Breitseiten wohl leichter. Anders ist der Erfolg von Elbow in Großbritannien nicht zu erklären.

Am Ende blieb das Gefühl, dass »Build a Rocket Boys!« kein Fehlkauf war, schon wegen des anrührenden »Lippy Kids«. Aber es ist keine CD für zwischendurch, es ist experimenteller BritPop mit vielen Facetten, nichts für den wippenden Fuß, keine Musik für den schnellen Konsum. Da stellen sich schon mal Parallelen zu Gentle Giant oder der frühen Genesis ein, und damit liegt man nicht falsch, denn der Sänger Guy Garvey ist ein alter Genesis-Fan, auch wenn es diese Band zu seiner Jugendzeit schon nicht mehr gab. Spröder, aber auch manchmal berührender BritPop, den man so noch nicht gehört hat. »Lippy Kids« ist nicht typisch für das Album, aber es gehört dazu, als ein Aspekt. Man kann das Album mögen, man muss es aber nicht.

Dreieinhalb von fünf möglichen Startversuchen.

Das Konzept ist alt, schon geradezu abgegriffen: bekannte Rock-Songs werden mit oder von Symphonieorchestern neu eingespielt. Damit haben schon Deep Purple in der Siebziger Jahren angefangen, EL&P sind gefolgt, Queen ebenso. Was ist bei Peter Gabriel anders? Nichts. Oder eben doch.

Nun war der frühere Genesis-Sänger und seit langer Zeit solo arbeitende Musiker schon immer für Überraschungen gut. Innovative Videos, faszinierende Live-Konzerte, das alles ohne Rockstar-Attitüden und -Skandale. Sein Studioalbum Up aus dem Jahre 2002 brachte Sounds, die man so noch nie gehört hatte. Gabriel hat die Fähigkeit, Weltmusik einzuarbeiten ohne dass es nach erzwungenem, gekünsteltem Multikulti klingt. Seine Texte, die zu einem nicht geringen Teil aus seiner Beschäftigung mit Psychoanalyse und -therapie stammen, waren manchmal Kleinodien und schon allein einer Interpretation wert. Innovation war Gabriels Thema, gelingt das auch mit dem New Blood Orchestra, das eigens für ihn zusammen gestellt wurde und mit dem er längere Zeit tourte?

Bedingt. Nun sind Gabriels Songs schon seit langer Zeit orchestral angelegt, und sie dann am Ende tatsächlich nur mit einem Orchester zu interpretieren, ist nicht so neu wie »Smoke On The Water« mit Streichern und Pauken. Es klingt nicht so wirklich anders, selbst neuere Songs, die in der bisherigen Version mit Synthklängen und mannigfaltigem Perkussion-Set aus dem Rahmen fielen, klingen hier nicht wirklich ungewohnt. Es ist ein wenig eine Falle, ein Hinterherlaufen hinter Trends, was Gabriel hier tut. Innovativ ist es nicht, ein Fortschritt auch nicht. Aber wo Gabriel drauf steht, ist wenigstens auch Gabriel drin.

»Wallflower«, »In Your Eyes«, »Mercy Street«, selbst »Darkness« vom oben genannten Album »Up« sind tatsächlich wunderschöne Interpretationen. Es ist toll orchestriert, wenn man Orchestermusik und Gabriel mag, die perfekte Kombination. Für hartgesottene Gabriel-Fans ist das Album ein Muss. Für den Rest bringt es nichts Überraschendes, außer man kennt seine Stücke noch gar nicht. Schade, aber Gabriel scheint sich dieses Mal nicht an das Experiment wagen zu wollen. Oder zu dürfen, es riecht zu sehr nach Marketing-Hype als nach Gabrielscher Kreativität. Und doch ist da diese Gabriel-Atmosphäre, der ich mich schlecht entziehen kann. Vielleicht, weil seine Musik einfach schöne und zeitlose Musik ist. Und es ringt mir immer wieder Respekt ab, einen solchen Haufen großartiger Musiker zu bändigen, denn qualitativ ist das allererste Sahne. Und endlich bekommen die Bassisten mal die Position, die ihnen gebührt. 🙂

Vier von fünf möglichen Erythrozyten.

Merkwürdig, wie sich Musik so festsetzen kann. Mir passiert mit dem Album Quiet Places des Paderborner Pianisten Arno Höddinghaus. Höddinghaus, 1967 in Paderborn geboren, durchlief zuerst eine klassische Klavierausbildung, spielte in den Achtzigern in Rockbands, begleitete seit 1989 den Detmolder Liedermacher Michael Motzek und veröffentlichte seit 1991 eigene Produktionen im musikalischen Spektrum zwischen New Age und Ambient. Vertrauter ist mir persönlich Arno Höddinghaus mit Projekten wie Songs From The Attic und Lost Songs, Interpretationen von Singer/Songwritern mit der Sängerin Heike Düppe. Um so überraschter war ich von diesem Album, das eher dem Spektrum Musique concrète zuzuordnen ist. Spontan fiel mir beim ersten Hören von Quiet Places das epische Sonic Seasonings von Wendy Carlos ein, weniger die klassischen Vertreter wie Pierre Schaeffer oder Pierre Boulez, denn wie Carlos nimmt konkrete Klänge und Stimmungen auf und ergänzt mit Musik.

Quiet Places sind Aufnahmen von realen Orten mit ihrer akustischen Vielfalt, unterlegt von synthetischen Sprenkeln und Effekten, eingerahmt durch ein zurückhaltendes und geradezu schüchternes Piano. Dass sich so keine kurzen Stücke für Airplay beim WDR ergeben, ist einleuchtend. Es ist auch keine music for the masses, dazu ist sie zu speziell. Sie hat aber eine andere wichtigere Eigenschaft, die man bei nur wenig Musik findet, wie bei Chopins Nocturnes oder oft bei Satie, man kann sie ganz konzentriert und fokussiert hören und sich auf die vielen kleinen Versatzstücke einlassen. Oder sie kann im Hintergrund laufen, als Begleiter bei konzentrierter Arbeit, wie eine beruhigende Atmosphäre im Raum. Quiet Places ist ruhige, beruhigende und meditative Musik, und man spürt Höddinghaus' Sinn für das Notwendige, Reduzierte, nicht das Übertriebene wie bei Jordan Rudess oder das Expressive wie bei Keith Emerson oder Patrick Moraz. "Die Konzepte von Anregung und Entspannung sind selten zuvor so kunstvoll miteinander verwoben worden wie auf diesem Album.", schrieb der Journalist Frank Lechtenberg.

Dem kann ich mich nur anschließen.

Quiet Places gibt es zum freien Download auf Arno Höddinghaus' Homepage.

Was soll man von einer Gitarre halten, die ein Händler wie folgt beschreibt:

- Hersteller: Dimavery

- SG-Form, schwarz

- Hals: Ahorn

- Korpus laut Anbieter: Amerikanische Linde

- Griffbrett: Palisander, 22 Bünde

- Pickups: 2 x Humbucker

- Regler: 2 x Volumen, 2 x Ton

- PU Schalter: 3-Way Switch

- Brücke: Tune-O-Matic

- Preis: 79 Euro inkl. Versand

Meine erste Reaktion war, dass das nur Schrott sein kann, denn zuverlässige Instrumente renommierter Hersteller beginnen frühestens bei ca. 500 Euro. Was ist also mit so einem Instrument, würde es für einen Anfänger reichen, zum Beispiel für einen Jugendlichen, der gerne Gitarre lernen möchte, aber es eventuell auch nach drei Monaten wieder aufsteckt?

Herkunft

Hergestellt werden die Instrumente, die unter dem Namen Dimavery verkauft werden, vermutlich in China. Import und Vertrieb übernimmt eine Firma Steinigke Showtechnic GmbH im bayrischen Waldbüttelbrunn. Und das nicht nur für Gitarren unterschiedlichster Coleur, sondern auch für Schlagzeuge, Verstärker bis hin zu Lichtsystemen für die Bühne. Diese Firma gibt es schon seit 1993, also kann es zumindestens kein Betrug sein. Alles, was ins Haus stünde, wäre eine herbe Enttäuschung. Aber warum nicht, bestelle ich einen solchen SG-Klon mal und sehe, was ankommt.

Lieferant ist hier die Firma Redcoon, ein eher gesettleter Internet-Anbieter für Elektronik. Und wie von ihm gewohnt, ist die Bestellung nach 48 Stunden in meinen Händen. Verpackt in einem üblichen Karton, das Instrument steckt gut geschützt in einer Plastiktüte in einem einfachen Gigbag, nichts Besonderes, aber zweckmäßig. Auch ein kürzeres Kabel ist dabei, keine Pleks oder ein Gurt, wie in der Anzeige von Redcoon versprochen. Nun gut, bei diesem Preis mag das so vorkommen.

Nach dem Auspacken erste Verblüffung: die Anmutung der Gitarre ist nicht Billigstschrott. Zwar ist die mattschwarze Lackierung kein Meisterstück, es gibt ein paar Dellen und einen Spalt zwischen Decke und Korpus, aber es ist weitaus besser als vermutet. Selbst Bridge und Stoptail sehen nicht übel aus, alles ordentlich verchromt. Alle Kunststoff- und Metallteile sind abgeklebt, die Tuner funktionieren im Grunde ohne Fehl und Tadel. Eine Demontage des Reglerfachs bringt wenigstens Holz zum Vorschein, es ist kein Schichtholz. Und der Setup aus der Fabrik ist grundsätzlich akzeptabel, die Saitenlage mittel, nicht für Flitzefinger, Intonation stimmt überraschend, generell ok. Nein, die 79 Euro sieht man der Gitarre erst mal nicht an.

Dann lassen wir mal einen gestandenen Gitarristen ran ...

So,

Rainer war gestern bei mir (Spaltertreffen) und wir nahmen das gute Stück in Augenschein. Zu den Materialien kann Rainer euch mehr sagen. Ich sage erstmal was zum generellen Eindruck: gut verarbeitet, nicht super, aber keine, keine offensichtlichen Schlampereien. Werkssetup besser als manches von bekannten Namen.

Der Body dieser 79€ SG ist bleischwer. Es soll Birke sein (nee, ist Linde, Ferdi; d. Red.), die ja zu den Harthölzern zählt, und nicht zu den leichtesten. Eine Les Paul von diesem Hersteller wird es wohl eher nicht geben. Nochmal: die Gitarre fällt zuallererst durch ihr Gewicht auf. Von der Hoffnung, Kopflastigkeit könne bei einem so schweren Body ja kein Thema sein, stirbt auch der letzte Rest bei der Gurtprobe. Der Hals ist ebenfalls bleischwer und pendelt sich am Gurt in der Waagerechten ein. Mit einem glatten, nicht aufgerauten Gurt hängt die Dame quer, nichts zu machen. Von dem federleichten SG-Charme ist insgesamt da nicht zu spüren... die Küchenwaage sagt 3981g.

Die Bundbearbeitung ist ok. Nicht super, aber ok. Keine scharfen Grate - nirgens. Meine Squier Tele greift sich sympathischer, aber der Fretjob ist nicht besser. Das Griffbrett ist in ein Bindung gefasst (die Bundenden nicht), das auch ok verarbeitet ist. Keine Patzer. Die Griffbretteinlagen können sich sehen lassen, mit der Ausnahme von einer einzigen sind es echt schmucke und gut passend eingesetzte Perlmutt-Kopien.

Hm, hm, hm. Der Lack ist lückenlos und scheint steinhart. Das ist ja eher gut. Kein (gibsontypischen) "Stufen" im Lack (am Übergang von lackiert zu nicht lackiert). Die Hardware erfüllt ihren Job (keine Verstimmungen seitens der Mechaniken zB), ist aber aus billigem Guss. Die Elektrik ist, oh wunder, extrabillig. Dickes Plus: keine Pickup-Mikrofonie. Keine. Nachdem ich den Halspickup weit runtergeschraubt hatte und den am Stege weiter rauf, waren die Lautstärkeverhältnisse ok.

Kommen wir zur Praxis 🙂

Fuhrpark:

- DiMavery SG, schwarz wie die Nacht

- vintage "no name" Spiralkabel (mein bestes bestes bestes)

- Boss TU2

- VoodooLab Microvibe

- Boss FZ-5 Fuzz

- Analogman KingOfTone

- MXR Carbon Copy

- Klotz Kabel

- "modded by Ritter Amps" JTM 45

- vertikale TT 2x12 mit Electro Voice (!!!) 12L und Tonehunter G12H.

Alles nur vom Feinsten, wenn es sch**** klingt, kann es also nur an der Gitarre liegen 🙂

So: Clean oder Crunch kommt eine Spur dünner, plärriger und blecherner Klang immer durch - das leisten vor allem die Pickups, denke ich - und zum Solieren, sorry, greift sie sich einfach zu unsexy, lässt sich der Ton zu wenig modulieren, der Ton lässt sich durch Bendings und Vibrato einfach nicht so richtig zum Blühen brinmgen - sie tut nicht, was ich will. Das "sie ist ein Teil von mir"-Gefühl will sich so gar nicht einstellen. Akkorde klingen aber einigermaßen gleichmäßig aus. Zum heavy Abrocken mit Akkordgeschrammel - so Black Sabbath-Rhythmuszeuch zB - tut sie es aber. Das kann schon richtig Spaß machen.

Ich würde sagen, für eine so hell klingende Holzbasis - der typische SG-Mahagoni-Ton ist so gar nicht da - müssten da mindestens ausgeprägt warm klingende, vielleicht sogar richtig heiße Pickups rein, ev. sogar ein Super Distortion am Steg und was Passendes in die Halsposition. Dann würde aus der sustainmäßig an sich gesunden Substanz unterm Strich ein Sound, mit dem man arbeiten kann. Für den Riffrocker wäre das dann eine brauchbare Arbeitsgitarre. Für den Solisten eher weniger.

Soweit erstmal. Preis/Leistung ist erstaunlich.

Nun legt der gestandene Gitarrist natürlich die Latte ein wenig höher. Aber sagen wir mal so: hätte ich einen jungen Sohn, der unbedingt Gitarre spielen möchte, und bei dem ich nicht weiß, wie lange er es durch hält, würde ich ein solches Instrument in Betracht ziehen. Mit einem Satz gebrauchter, ordentlicher Pickups, einem kleinen Amp aus der Transistorfraktion und ein oder zwei Tretminen soll der Youngster zeigen, dass er durch hält. Tut er es, geht es nach einem Jahr zum Musikhändler meines Vertrauens und man begutachtet Fender, Gibson oder sonst etwas. Wirft er aus irgendwelchen Gründen das Handtuch, sind 100 Euro und das Delta aus dem Verkauf des Amps investiert, aber mehr auch nicht.

Der Gerechtigkeit halber muss man aber erwähnen, dass eine Epiphone Les Paul Standard bei Thomann auch für 99 Euro zu bekommen ist, eine SG Junior für 88 Euro, und bei ca. 150 Euro beginnen die Squier-Instrumente a la Tele und Strat. Gerade den Squier-Gitarren kann man mehr zutrauen, und sie sind bei der Gesamtinvestitionssumme dann nur ein Teil des Betrages, der 50 Euro oder wenig mehr ausmacht.

Also bitte auf der Straße bleiben und nicht zu viel, aber auch nicht zu wenig erwarten. Für 79 Euro ist diese Dimavery-SG ein akzeptables Angebot und erfüllt definierte Zwecke. Eine PRS oder Gibson SG Standard kann dann ja später kommen.

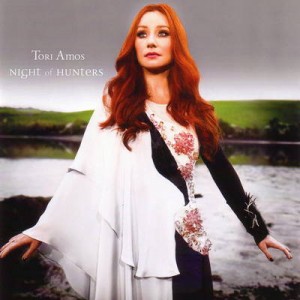

Es war still geworden um Tori Amos. Nach den anfänglichen Erfolgen mit Little Earthquakes, Under the Pink und Boys for Pele in den Neunziger Jahren, mit dem Cornflake Girl und Crufify. Die folgenden Veröffentlichungen waren oft sperrig, schwergängig. Ob nun Night of Hunters erfolgreicher wird? Ich befürchte fast nicht.

Tori Amos ist zu ihren Wurzeln zurück gegangen, zur klassischen Musik, die sie als Mädchen lernen und spielen musste, aber nicht wollte. Und deshalb aus dem Studium ausstieg, obwohl sie als sehr talentierte Pianistin galt. Nun hat sie diese Spuren der Vergangenheit wieder hervor geholt, Satie und Bach, Schubert und Debussy. Interessanterweise alles Komponisten, die ich kenne und schätze, was mich umso neugieriger auf ihre Sicht dieser Musik machte. Diesen klassischen Grundlagen hat sie neue Melodien und Texte hinzugefügt und daraus eine Sammlung von 14 mehr oder weniger freien Interpretationen klassischer und bekannter Stücke gemacht. Ein mutiges Unterfangen.

Wie gelungen ist das Ganze geworden? Ich bin zwiespältig. Einerseits ist diese Musik großartig, die große Pianistin Tori Amos scheint immer wieder durch, wer weiß, was auf dem geraden Weg aus ihr geworden wäre. Sicher ein Name in der Welt der klassischen Pianisten. Andererseits passt Amos' Art des Gesangs und ihre Art der Melodiebildung selten wirklich zum Ausgangsmaterial. Es bleibt meistens künstlich, am extremsten kommt dies bei Satie und Bach zum Vorschein. Das passt nicht wirklich zusammen, diese Harmonik, die Melodien und der Gesang. Sicher muss man solche Experimente wagen, auch Walter/Wendy Carlos ist in den Sechzigern für verrückt erklärt worden, als er/sie Bach auf dem Moog spielte. Aber Tori Amos bleibt zu nahe bei den klassischen Vorlagen und zu wenig bei sich selbst. So funktioniert das wenig. Eigentlich gar nicht. Schade.

Weitere Hörbeispiele finden sich in YouTube.

Zwei von fünf möglichen Cornflakes.

Normalerweise schätze ich Live-Aufnahmen eher weniger. Weil die Soundqualität meistens nicht stimmt, doch bei dieser Aufnahme habe ich zuerst gar nicht gemerkt, dass es eine Live-Aufnahme ist, so perfekt ist die Qualität, so dicht und right-into-your-face. Und weil das Feeling des Gigs nicht zuhause im Wohnzimmer ankommt, weil man nur hört, nicht fühlt und sieht. Diese CD hat mich eines Besseren belehrt.

Die Sammlung von Live-Auftritten des amerikanischen Pianisten und Keyboaders Bruce Hornsby und seiner Band The Noisemakers aus den Jahren 2007 bis 2009 arbeitet sich in unglaublich konsistenter Form durch altes und aktuelles Material. Was die Aufnahmen so hörenswert macht, ist nicht nur die wortwörtliche Spielfreude der Band, sondern auch die beachtliche Flexibilität von Bruce Hornsby, seine unglaublichen Live-Fähigkeiten. Da wird aus vier einzelnen Songs plötzlich einer, da geht es nahtlos von Fortunate Son (Hornsby) zu Comfortably Numb (Pink Floyd), wobei das Publikum erst einige Zeit braucht, es zu begreifen. Hornsby lavriert dabei oft an der schwierigen Grenze zwischen Jazz und Pop, und er ist einer der wenigen Musiker, die das können ohne sich selbst nicht treu zu bleiben. Die sogar Free Jazz-Elemente einbauen können, ohne gezwungen oder krampfhaft zu wirken. Die von Pop bis Jazz authentisch bleiben. Und auch noch alles an Stilen verwursten, bis das Original kaum mehr erkennbar bleibt.

Das Resultat ist eine Live-Musik, die sich qualitativ nicht hinter Studioaufnahmen zu verstecken braucht, dafür noch zusätzlich eine Lebendigkeit und einen Abwechselungsreichtum bieten, der Studioaufnahmen eben abgeht. Für Hornsby-Fans absolutes Must-Have, für Noch-Nicht-Fans eine Möglichkeit, mit diesem großen amerikanischen Musiker warm zu werden.

Fünf von fünf möglichen Pianotasten.

Bruce Hornsby and the Noisemakers - "Funhouse"

from Bruce Hornsby on Vimeo.

Bruce Hornsby and the Noisemakers - "White-Wheeled Limousine"

from Bruce Hornsby on Vimeo.